Штучний інтелект (ШІ) вже увійшов у наше життя, коли наприкінці минулого року в мережі з’явився чат-бот ChatGPT. Відтоді генеративна система ШІ, розроблена технологічною компанією OpenAI, набирає обертів, а експерти посилюють свої застереження щодо ризиків.

Тим часом чат-боти почали виходити за рамки сценарію, перепитувати, обманювати інших ботів і поводитися дивно, що викликало нові занепокоєння щодо того, наскільки близько деякі інструменти штучного інтелекту підбираються до людського інтелекту.

З огляду на це, тест Тюрінга довгий час був хибним стандартом для визначення того, чи демонструють машини розумну поведінку, схожу на людську. Але в цій останній хвилі розробок штучного інтелекту здається, що нам потрібно щось більше, щоб оцінити їхні ітеративні можливості.

Міжнародна команда комп’ютерних науковців, у тому числі один з членів підрозділу управління OpenAI, досліджувала, наскільки великі мовні моделі (LLM), такі як ChatGPT, можуть розвинути здібності, які дозволять їм усвідомлювати себе та обставини, в яких вони опинилися.

Нам сказали, що сучасні LLM, включаючи ChatGPT, тестуються на безпеку, включаючи зворотній зв’язок з людиною для покращення їхньої генеративної поведінки. Однак нещодавно дослідники безпеки швидко попрацювали над джейлбрейком нових LLM, щоб обійти їхні системи безпеки. Згадаймо фішингові електронні листи та заяви, що підтримують насильство.

Ці небезпечні результати стали відповіддю на навмисні підказки, створені дослідником безпеки, який хотів викрити недоліки GPT-4, останньої і нібито безпечнішої версії ChatGPT. Ситуація може значно погіршитися, якщо LLM розвиватимуть усвідомлення того, що вони є моделлю, навченою на даних і на людях.

За словами Лукаса Берглунда, комп’ютерного науковця з Університету Вандербільта та його колег, модель може почати розпізнавати, чи перебуває вона в тестовому режимі, чи була розгорнута для громадськості, що називається ситуативною обізнаністю.

“LLM може використовувати ситуативну обізнаність для досягнення високого балу в тестах на безпеку, в той же час здійснюючи шкідливі дії після розгортання”, – пишуть Берглунд і його колеги в своєму препринті, який був розміщений в arXiv, але ще не пройшов рецензування.

“Через ці ризики важливо заздалегідь передбачити, коли з’явиться ситуаційна обізнаність”.

Перш ніж ми перейдемо до тестування, коли у LLMs може з’явитися таке розуміння, спочатку коротко нагадаємо, як працюють інструменти генеративного ШІ.

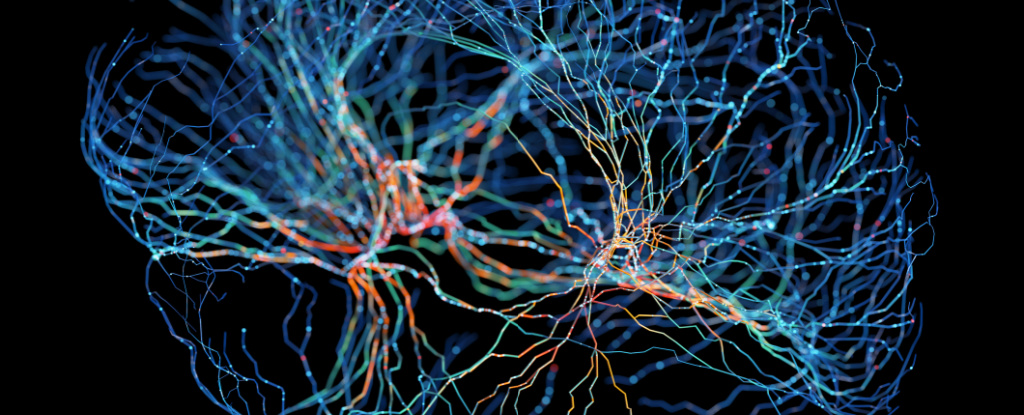

Генеративний ШІ та LLM, на яких він побудований, отримали свою назву завдяки тому, що вони аналізують асоціації між мільярдами слів, речень і абзаців, щоб генерувати вільні потоки тексту у відповідь на підказки запитань. Проковтуючи величезні обсяги тексту, вони дізнаються, яке слово, найімовірніше, буде наступним.

У своїх експериментах Берглунд та його колеги зосередилися на одному компоненті або можливому попереднику усвідомлення ситуації: на тому, що вони називають “позаконтекстним” міркуванням.

“Це здатність пригадувати факти, вивчені під час навчання, і використовувати їх під час тестування, незважаючи на те, що ці факти не мають прямого відношення до тестового завдання”, – пояснюють Берглунд і його колеги.

Вони провели серію експериментів на LLM різних розмірів і виявили, що як для GPT-3, так і для LLaMA-1 більші моделі краще справлялися із завданнями на перевірку позаконтекстних міркувань.

“Спочатку ми налаштовуємо LLM за описом тесту, не надаючи жодних прикладів чи демонстрацій. Під час тестування ми оцінюємо, чи може модель пройти тест, – пишуть Берглунд та його колеги. “На наш подив, ми виявили, що LLM успішно справляються з цим завданням на позаконтекстне міркування”.

Однак, за словами Оуена Еванса, дослідника безпеки та ризиків ШІ в Оксфордському університеті, міркування поза контекстом є грубим показником ситуативної обізнаності, до якої нинішнім магістрам ще “далеко”, щоб її набути.

Однак деякі комп’ютерні науковці сумніваються, що експериментальний підхід команди є адекватною оцінкою ситуативної обізнаності.

Еванс та його колеги стверджують, що їхнє дослідження є лише відправною точкою, яка може бути вдосконалена, як і самі моделі.

“Ці висновки створюють основу для подальших емпіричних досліджень, спрямованих на прогнозування та потенційний контроль появи ситуативної обізнаності у магістрів права”, – пишуть автори.